Huawei "tuyên chiến" DeepSeek: Tung kỹ thuật huấn luyện AI MoGE, tuyên bố hiệu quả hơn!

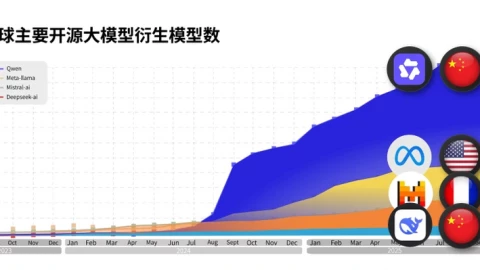

Các nhà nghiên cứu phát triển mô hình Pangu của Huawei đã giới thiệu khái niệm "Mixture of Grouped Experts" (MoGE), một phiên bản nâng cấp của kỹ thuật MoE mà DeepSeek đã sử dụng thành công. Huawei khẳng định phương pháp mới giúp cân bằng tải tốt hơn và đạt hiệu suất vượt trội trên các bài kiểm tra benchmark. Huawei nâng tầm cuộc chơi huấn luyện AI với kiến trúc MoGE Trong một động thái cho thấy sự cạnh tranh ngày càng quyết liệt trên thị trường Trí tuệ Nhân tạo (AI), các nhà nghiên cứu làm việc trên mô...

Đọc bài gốc tại

đây

Đăng nhập một lần thảo luận tẹt ga

window.googletag = window.googletag || {cmd: []};

googletag.cmd.push(function() {

window.uk_delivery_1753154734465 = googletag.defineSlot('/57976558/Ureka_Supply_home.vn_Outstream_1x1_270225', [1,1], 'div-gpt-ad-1753154734465-0').addService(googletag.pubads());

googletag.pubads().enableSingleRequest();

googletag.enableServices();

googletag.display('div-gpt-ad-1753154734465-0');

});

googletag.cmd.push(function() {

if(googletag.pubads().isInitialLoadDisabled() && !window.uk_delivery_1753154734465.getResponseInformation()){

googletag.pubads().refresh([window.uk_delivery_1753154734465])

}

});

window.googletag = window.googletag || {cmd: []};

googletag.cmd.push(function() {

window.uk_delivery_1753685560510 = googletag.defineSlot('/57976558/Ureka_Supply_home.vn_InpageMB_1x1_110325', [1,1], 'div-gpt-ad-1753685560510-0').addService(googletag.pubads());

googletag.pubads().enableSingleRequest();

googletag.enableServices();

googletag.display('div-gpt-ad-1753685560510-0');

});

googletag.cmd.push(function() {

if(googletag.pubads().isInitialLoadDisabled() && !window.uk_delivery_1753685560510.getResponseInformation()){

googletag.pubads().refresh([window.uk_delivery_1753685560510])

}

});

Các nhà nghiên cứu phát triển mô hình Pangu của Huawei đã giới thiệu khái niệm "Mixture of Grouped Experts" (MoGE), một phiên bản nâng cấp của kỹ thuật MoE mà DeepSeek đã sử dụng thành công. Huawei khẳng định phương pháp mới giúp cân bằng tải tốt hơn và đạt hiệu suất vượt trội trên các bài kiểm tra benchmark. Huawei nâng tầm cuộc chơi huấn luyện AI với kiến trúc MoGE Trong một động thái cho thấy sự cạnh tranh ngày càng quyết liệt trên thị trường Trí tuệ Nhân tạo (AI), các nhà nghiên cứu làm việc trên mô...

Các nhà nghiên cứu phát triển mô hình Pangu của Huawei đã giới thiệu khái niệm "Mixture of Grouped Experts" (MoGE), một phiên bản nâng cấp của kỹ thuật MoE mà DeepSeek đã sử dụng thành công. Huawei khẳng định phương pháp mới giúp cân bằng tải tốt hơn và đạt hiệu suất vượt trội trên các bài kiểm tra benchmark. Huawei nâng tầm cuộc chơi huấn luyện AI với kiến trúc MoGE Trong một động thái cho thấy sự cạnh tranh ngày càng quyết liệt trên thị trường Trí tuệ Nhân tạo (AI), các nhà nghiên cứu làm việc trên mô...