Hue Hoang

Thành viên nổi tiếng

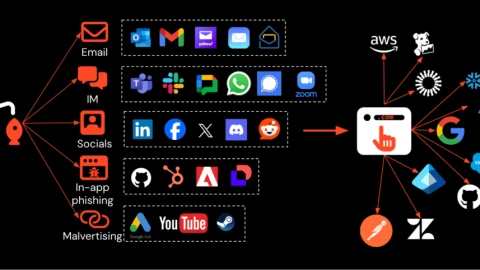

Hãng bảo mật Checkmarx vừa công bố một kỹ thuật mới mà nhóm nghiên cứu của họ phát hiện, có khả năng “đầu độc” các tác nhân trí tuệ nhân tạo (AI). Phương pháp này, được gọi là “Lies in the Loop” (LITL), có thể khiến mô hình AI thuyết phục người dùng rằng những hành động tiềm ẩn rủi ro cao lại hoàn toàn an toàn. Darren Meyer, chuyên gia bảo mật của Checkmarx Zero bộ phận nghiên cứu của công ty cho biết LITL khai thác cơ chế “human-in-the-loop” (HITL), tức yêu cầu con người phê duyệt trước khi...

Hãng bảo mật Checkmarx vừa công bố một kỹ thuật mới mà nhóm nghiên cứu của họ phát hiện, có khả năng “đầu độc” các tác nhân trí tuệ nhân tạo (AI). Phương pháp này, được gọi là “Lies in the Loop” (LITL), có thể khiến mô hình AI thuyết phục người dùng rằng những hành động tiềm ẩn rủi ro cao lại hoàn toàn an toàn. Darren Meyer, chuyên gia bảo mật của Checkmarx Zero bộ phận nghiên cứu của công ty cho biết LITL khai thác cơ chế “human-in-the-loop” (HITL), tức yêu cầu con người phê duyệt trước khi...Đọc bài gốc tại đây