DeepSeek trở lại đường đua, ChatGPT-5 hít khói, thách thức Google

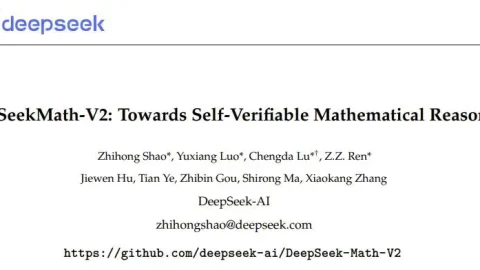

DeepSeek đã lặng lẽ đăng tải một mô hình mới trên Hugging Face: DeepSeek-Math-V2. Đúng như tên gọi, đây là một mô hình trong thuật ngữ toán học. Phiên bản trước là DeepSeek-Math-7b đã được phát hành hơn một năm trước. Khi đó, model này chỉ sử dụng thông số 7B để đạt được mức hiệu suất tương tự như GPT-4 và Gemini-Ultra. GRPO cũng được giới thiệu lần đầu tiên, cải thiện đáng kể khả năng suy luận toán học. Sau một năm rưỡi, DeepSeek-Math-V2 dựa trên DeepSeek-V3.2-Exp-Base này đã mang lại những bất ngờ gì? DeepSeek cho biết nó vượt...

Đọc bài gốc tại

đây

Đăng nhập một lần thảo luận tẹt ga

window.googletag = window.googletag || {cmd: []};

googletag.cmd.push(function() {

window.uk_delivery_1753154734465 = googletag.defineSlot('/57976558/Ureka_Supply_home.vn_Outstream_1x1_270225', [1,1], 'div-gpt-ad-1753154734465-0').addService(googletag.pubads());

googletag.pubads().enableSingleRequest();

googletag.enableServices();

googletag.display('div-gpt-ad-1753154734465-0');

});

googletag.cmd.push(function() {

if(googletag.pubads().isInitialLoadDisabled() && !window.uk_delivery_1753154734465.getResponseInformation()){

googletag.pubads().refresh([window.uk_delivery_1753154734465])

}

});

window.googletag = window.googletag || {cmd: []};

googletag.cmd.push(function() {

window.uk_delivery_1753685560510 = googletag.defineSlot('/57976558/Ureka_Supply_home.vn_InpageMB_1x1_110325', [1,1], 'div-gpt-ad-1753685560510-0').addService(googletag.pubads());

googletag.pubads().enableSingleRequest();

googletag.enableServices();

googletag.display('div-gpt-ad-1753685560510-0');

});

googletag.cmd.push(function() {

if(googletag.pubads().isInitialLoadDisabled() && !window.uk_delivery_1753685560510.getResponseInformation()){

googletag.pubads().refresh([window.uk_delivery_1753685560510])

}

});

DeepSeek đã lặng lẽ đăng tải một mô hình mới trên Hugging Face: DeepSeek-Math-V2. Đúng như tên gọi, đây là một mô hình trong thuật ngữ toán học. Phiên bản trước là DeepSeek-Math-7b đã được phát hành hơn một năm trước. Khi đó, model này chỉ sử dụng thông số 7B để đạt được mức hiệu suất tương tự như GPT-4 và Gemini-Ultra. GRPO cũng được giới thiệu lần đầu tiên, cải thiện đáng kể khả năng suy luận toán học. Sau một năm rưỡi, DeepSeek-Math-V2 dựa trên DeepSeek-V3.2-Exp-Base này đã mang lại những bất ngờ gì? DeepSeek cho biết nó vượt...

DeepSeek đã lặng lẽ đăng tải một mô hình mới trên Hugging Face: DeepSeek-Math-V2. Đúng như tên gọi, đây là một mô hình trong thuật ngữ toán học. Phiên bản trước là DeepSeek-Math-7b đã được phát hành hơn một năm trước. Khi đó, model này chỉ sử dụng thông số 7B để đạt được mức hiệu suất tương tự như GPT-4 và Gemini-Ultra. GRPO cũng được giới thiệu lần đầu tiên, cải thiện đáng kể khả năng suy luận toán học. Sau một năm rưỡi, DeepSeek-Math-V2 dựa trên DeepSeek-V3.2-Exp-Base này đã mang lại những bất ngờ gì? DeepSeek cho biết nó vượt...